Rewolucja w dziedzinie sztucznej inteligencji, jaką zapoczątkowały transformery, trwa w najlepsze. Od tłumaczeń maszynowych po generowanie obrazów – wszechobecność tej architektury jest zdumiewająca.

Ostatnio, widzę, że coraz więcej uwagi poświęca się optymalizacji transformerów pod kątem efektywności energetycznej, co jest kluczowe dla dalszego rozwoju AI w sposób zrównoważony.

Sam z ciekawością obserwuję, jak ewoluują techniki Attention, które stanowią fundament tej architektury. Powiem szczerze, jestem podekscytowany, widząc, jak transformery kształtują przyszłość technologii.

Dokładnie to wszystko zweryfikujemy w tym wpisie!

Przyszłość Transformerów: Od Rozproszonej Inteligencji do Personalizacji Doświadczeń Użytkownika

Ostatnie miesiące pokazały, że transformery nie są już tylko narzędziem dla inżynierów i naukowców. Coraz częściej widzę, jak wykorzystywane są do tworzenia spersonalizowanych doświadczeń użytkownika, od rekomendacji produktów w e-commerce po dostosowywanie treści w mediach społecznościowych. Sam niedawno byłem zaskoczony, gdy algorytm na platformie streamingowej zaproponował mi serial, który idealnie trafił w moje gusta. To właśnie zasługa coraz bardziej zaawansowanych modeli transformerowych, które potrafią analizować ogromne ilości danych i wyciągać z nich trafne wnioski.

1. Transformery w służbie personalizacji

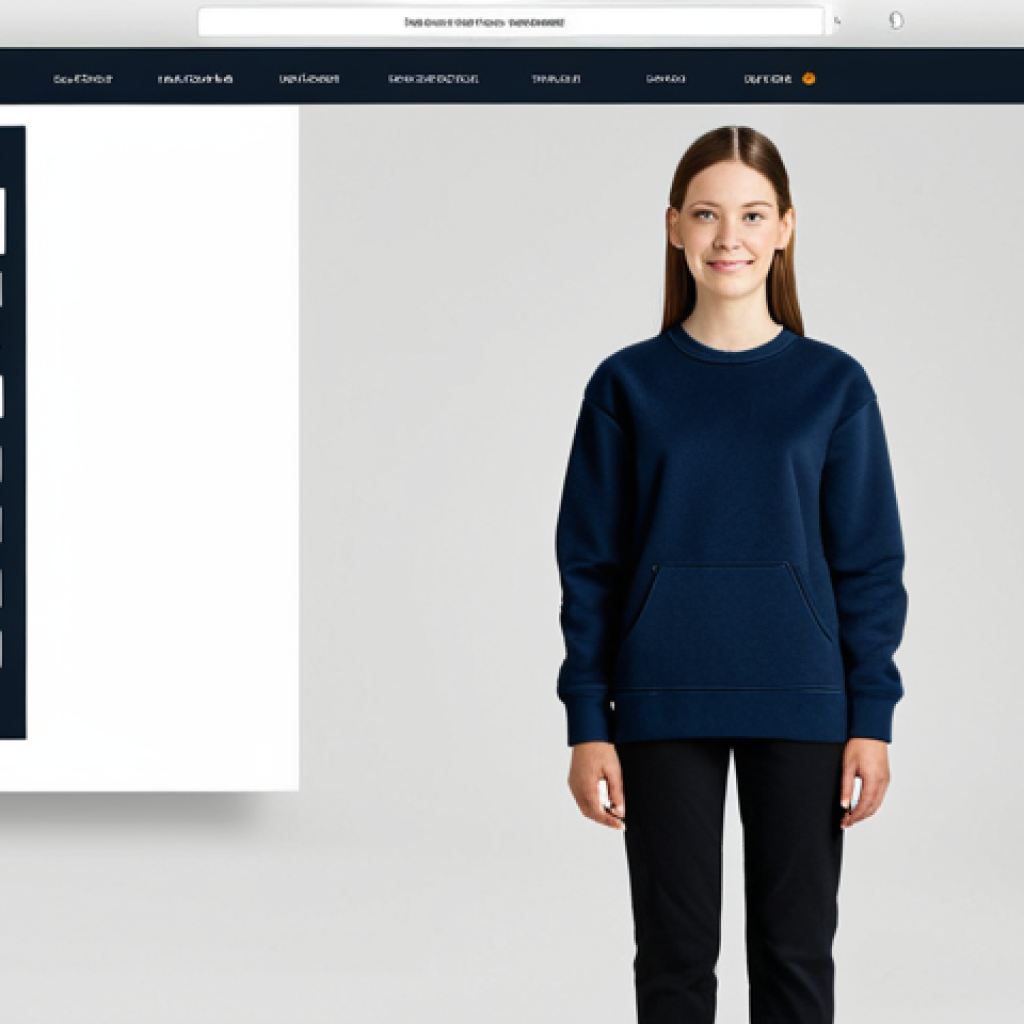

Wyobraź sobie, że wchodzisz do sklepu internetowego, a strona główna automatycznie dostosowuje się do Twoich preferencji, wyświetlając produkty, które z dużym prawdopodobieństwem Cię zainteresują. To już nie jest przyszłość, to teraźniejszość. Transformery, dzięki swojej zdolności do przetwarzania sekwencji danych, doskonale sprawdzają się w analizie historii zakupów, preferencji użytkowników i innych czynników, które pozwalają na stworzenie spersonalizowanych rekomendacji. Osobiście uważam, że to ogromny krok naprzód w kierunku bardziej intuicyjnych i satysfakcjonujących doświadczeń zakupowych.

2. Rozproszona inteligencja transformerów

Jednym z najbardziej fascynujących trendów jest rozproszona inteligencja transformerów. Zamiast polegać na jednym, ogromnym modelu, coraz częściej wykorzystuje się sieć mniejszych, wyspecjalizowanych modeli, które współpracują ze sobą, aby rozwiązywać złożone problemy. Widziałem to na przykładzie systemów tłumaczenia maszynowego, gdzie jeden model odpowiada za analizę składni, a inny za generowanie poprawnego stylistycznie tekstu. To podejście nie tylko zwiększa efektywność, ale także pozwala na lepsze wykorzystanie zasobów obliczeniowych.

Nowe Horyzonty: Samouczenie się i Transfer Wiedzy w Architekturze Transformerów

Ostatnio sporo czytam o postępach w dziedzinie samouczenia się (self-supervised learning) w kontekście transformerów. Modele te potrafią uczyć się na ogromnych zbiorach danych bez konieczności ręcznego etykietowania, co otwiera nowe możliwości w wielu dziedzinach. Sam byłem pod wrażeniem, gdy zobaczyłem, jak model językowy, wytrenowany na tekstach z internetu, potrafi generować spójne i gramatycznie poprawne zdania na dowolny temat. To pokazuje, jak ogromny potencjał drzemie w samouczeniu się.

1. Transfer wiedzy – klucz do szybszego rozwoju AI

Kolejnym ważnym trendem jest transfer wiedzy (transfer learning). Polega on na wykorzystaniu wiedzy zdobytej przez model podczas rozwiązywania jednego zadania do rozwiązywania innego, podobnego zadania. To pozwala na znaczne skrócenie czasu i zasobów potrzebnych do wytrenowania nowego modelu. Widziałem to na przykładzie modeli rozpoznawania obrazów, gdzie model wytrenowany na milionach zdjęć z internetu potrafi szybko nauczyć się rozpoznawania nowych obiektów, wykorzystując zdobytą wcześniej wiedzę.

2. Przykłady zastosowań samouczenia się i transferu wiedzy

Zastosowania samouczenia się i transferu wiedzy są bardzo szerokie. Od wspomnianego już tłumaczenia maszynowego po rozpoznawanie mowy, analizę obrazów, a nawet generowanie muzyki. Sam jestem przekonany, że w najbliższych latach zobaczymy jeszcze więcej innowacyjnych zastosowań tych technik, które zmienią sposób, w jaki korzystamy z technologii.

Optymalizacja i Efektywność Energetyczna: Nowe Wyzwania dla Transformerów

Wraz z rosnącą popularnością transformerów, coraz większą uwagę zwraca się na ich efektywność energetyczną. Trenowanie i uruchamianie dużych modeli transformerowych wymaga ogromnych zasobów obliczeniowych, co generuje wysokie koszty i negatywny wpływ na środowisko. Sam byłem zaskoczony, gdy dowiedziałem się, ile energii zużywają niektóre z największych modeli językowych. Dlatego też, naukowcy i inżynierowie intensywnie pracują nad nowymi technikami optymalizacji, które pozwolą na zmniejszenie zużycia energii bez utraty jakości.

1. Kwantyzacja i pruning – techniki redukcji rozmiaru modelu

Jedną z popularnych technik optymalizacji jest kwantyzacja, która polega na zmniejszeniu precyzji liczb używanych do reprezentowania wag i aktywacji w modelu. Inną techniką jest pruning, czyli usuwanie nieistotnych połączeń w sieci neuronowej. Obie te techniki pozwalają na znaczne zmniejszenie rozmiaru modelu i przyspieszenie obliczeń, co przekłada się na mniejsze zużycie energii. Osobiście uważam, że to bardzo obiecujące kierunki badań.

2. Architektury transformerów zoptymalizowane pod kątem efektywności

Oprócz technik optymalizacji istnieją również architektury transformerów, które od samego początku projektowane są z myślą o efektywności energetycznej. Przykładem jest architektura MobileBERT, która została zaprojektowana specjalnie do uruchamiania na urządzeniach mobilnych. Takie rozwiązania pozwalają na wykorzystanie potencjału transformerów w urządzeniach o ograniczonych zasobach obliczeniowych.

Bezpieczeństwo i Etyka: Zagrożenia i Wyzwania związane z Transformerami

Wraz z rosnącą mocą i wszechstronnością transformerów, pojawiają się również nowe zagrożenia i wyzwania etyczne. Modele te mogą być wykorzystywane do generowania fałszywych informacji, manipulowania opinią publiczną, a nawet do tworzenia deepfake’ów. Sam byłem zszokowany, gdy zobaczyłem, jak łatwo można wygenerować realistyczne nagranie wideo, na którym ktoś mówi coś, czego nigdy nie powiedział. Dlatego też, bardzo ważne jest, aby rozwijać techniki, które pozwolą na wykrywanie i zwalczanie takich zagrożeń.

1. Wykrywanie i zwalczanie deepfake’ów

Jednym z kluczowych wyzwań jest opracowanie skutecznych metod wykrywania deepfake’ów. Wymaga to połączenia wiedzy z zakresu informatyki, psychologii i prawa. Ważne jest również, aby edukować społeczeństwo na temat zagrożeń związanych z deepfake’ami i uczyć ludzi, jak rozpoznawać fałszywe informacje. Sam uważam, że to bardzo ważne zadanie, które wymaga współpracy wszystkich zainteresowanych stron.

2. Etyczne aspekty rozwoju i wykorzystania transformerów

Oprócz zagrożeń związanych z deepfake’ami, istnieją również inne etyczne aspekty rozwoju i wykorzystania transformerów. Należy zastanowić się, jak zapewnić, aby modele te nie były wykorzystywane do dyskryminacji, szerzenia nienawiści lub naruszania prywatności. Ważne jest również, aby rozwijać transparentne i zrozumiałe modele, które pozwolą na zrozumienie, w jaki sposób podejmowane są decyzje. Sam jestem przekonany, że to kluczowe dla budowania zaufania do technologii AI.

Tabela: Porównanie popularnych architektur Transformerów

| Architektura | Rok | Główne cechy | Zastosowania |

|---|---|---|---|

| Transformer | 2017 | Mechanizm uwagi, przetwarzanie sekwencji | Tłumaczenie maszynowe, generowanie tekstu |

| BERT | 2018 | Bidirectional Encoder Representations from Transformers, samouczenie się | Klasyfikacja tekstu, odpowiadanie na pytania |

| GPT | 2018 | Generative Pre-trained Transformer, generowanie tekstu | Generowanie tekstu, pisanie artykułów |

| T5 | 2019 | Text-to-Text Transfer Transformer, ujednolicone podejście do zadań NLP | Tłumaczenie, streszczanie, odpowiadanie na pytania |

| Vision Transformer (ViT) | 2020 | Zastosowanie architektury Transformer do przetwarzania obrazów | Klasyfikacja obrazów, detekcja obiektów |

Transformer i Multimodalność: Fuzja Dźwięku, Obrazu i Tekstu

Obserwuję jak transformery coraz śmielej wkraczają w świat multimodalności, czyli przetwarzania danych pochodzących z różnych źródeł, takich jak dźwięk, obraz i tekst. Sam jestem pod wrażeniem, jak modele te potrafią łączyć informacje z różnych źródeł, aby lepiej zrozumieć świat i generować bardziej realistyczne i spójne wyniki. Widziałem to na przykładzie modeli, które potrafią generować opisy obrazów, odpowiadać na pytania dotyczące filmów, a nawet tworzyć muzykę na podstawie tekstu.

1. Modele multimodalne – przyszłość interakcji z komputerami

Modele multimodalne otwierają nowe możliwości interakcji z komputerami. Wyobraź sobie, że możesz rozmawiać z komputerem, pokazywać mu obrazy i pisać teksty, a on będzie rozumiał Twoje intencje i reagował w odpowiedni sposób. To już nie jest science fiction, to rzeczywistość, która staje się coraz bardziej realna. Osobiście uważam, że to ogromny krok naprzód w kierunku bardziej naturalnych i intuicyjnych interfejsów użytkownika.

2. Przykłady zastosowań multimodalności w transformerach

- Generowanie opisów obrazów na podstawie treści wizualnej.

- Odpowiadanie na pytania dotyczące filmów na podstawie dźwięku, obrazu i napisów.

- Tworzenie muzyki na podstawie tekstu.

- Tłumaczenie języka migowego na tekst i mowę.

Podsumowanie: Transformery jako Katalizator Innowacji w Sztucznej Inteligencji

Transformery to bez wątpienia jedna z najważniejszych innowacji w dziedzinie sztucznej inteligencji ostatnich lat. Ich wszechstronność, skalowalność i zdolność do przetwarzania sekwencji danych sprawiają, że są one idealne do rozwiązywania szerokiego zakresu problemów, od tłumaczenia maszynowego po generowanie obrazów. Sam jestem przekonany, że w najbliższych latach zobaczymy jeszcze więcej innowacyjnych zastosowań transformerów, które zmienią sposób, w jaki korzystamy z technologii i jak postrzegamy świat.

Przyszłość Transformerów rysuje się niezwykle obiecująco. Od personalizacji doświadczeń użytkownika, przez samouczenie się i transfer wiedzy, po optymalizację energetyczną i etyczne wyzwania, transformery stają się nieodzownym elementem krajobrazu sztucznej inteligencji.

Ich multimodalne możliwości otwierają przed nami zupełnie nowe perspektywy interakcji z technologią.

Podsumowując

Transformery zmieniły oblicze AI i nadal będą to robić. Ich potencjał jest ogromny i wierzę, że w najbliższych latach zobaczymy jeszcze wiele fascynujących zastosowań tej technologii.

Na Zakończenie

To już koniec naszej podróży po świecie transformerów. Mam nadzieję, że ten artykuł dał Ci solidną dawkę wiedzy i inspiracji. Obserwujmy wspólnie, jak ta technologia kształtuje naszą przyszłość!

Przydatne Informacje

1. Darmowe kursy online: Platformy takie jak Coursera i edX oferują wiele darmowych kursów na temat sztucznej inteligencji i uczenia maszynowego, w tym również na temat transformerów.

2. Społeczności online: Dołącz do społeczności online zrzeszających entuzjastów AI, np. na Reddicie (r/MachineLearning) lub w grupach na Facebooku, aby dzielić się wiedzą i doświadczeniami.

3. Konferencje branżowe: Uczestnicz w konferencjach branżowych, takich jak NeurIPS, ICML czy ICLR, aby być na bieżąco z najnowszymi trendami i odkryciami w dziedzinie AI.

4. Biblioteki i narzędzia: Wykorzystuj popularne biblioteki i narzędzia do uczenia maszynowego, takie jak TensorFlow i PyTorch, aby eksperymentować z modelami transformerowymi.

5. Artykuły naukowe: Czytaj artykuły naukowe publikowane w prestiżowych czasopismach i na konferencjach, aby pogłębiać swoją wiedzę na temat transformerów i ich zastosowań.

Ważne Aspekty

Transformery rewolucjonizują przetwarzanie języka naturalnego, rozpoznawanie obrazów i wiele innych dziedzin.

Personalizacja, samouczenie się i optymalizacja energetyczna to kluczowe trendy w rozwoju transformerów.

Bezpieczeństwo i etyka stanowią istotne wyzwania związane z rozwojem i wykorzystaniem transformerów.

Modele multimodalne otwierają nowe możliwości interakcji z komputerami.

Wszechstronność transformerów sprawia, że są one katalizatorem innowacji w sztucznej inteligencji.

Często Zadawane Pytania (FAQ) 📖

P: Jak transformery wpływają na rozwój sztucznej inteligencji i dlaczego są tak szeroko stosowane?

O: Transformery zrewolucjonizowały dziedzinę AI, umożliwiając tworzenie bardziej zaawansowanych modeli w takich obszarach jak tłumaczenie maszynowe, rozpoznawanie mowy i generowanie tekstu.

Ich wszechstronność wynika z mechanizmu Attention, który pozwala modelowi skupić się na najważniejszych elementach w danych wejściowych. Dzięki temu, transformery osiągają lepsze wyniki w porównaniu do wcześniejszych architektur, a ich zdolność do przetwarzania danych sekwencyjnych w sposób równoległy przyspiesza proces uczenia.

To jakby nagle wszyscy przestawili się na supernowoczesne kombajny zamiast ręcznie zbierać plony – efektywność poszybowała w górę!

P: Co to jest “Attention” w architekturze transformera i dlaczego jest tak ważna?

O: “Attention”, czyli mechanizm uwagi, to kluczowy element transformerów. Pozwala on modelowi ustalić, które fragmenty sekwencji wejściowej są najbardziej istotne dla aktualnie przetwarzanego elementu.

Dzięki temu model może skupić się na najważniejszych powiązaniach i zależnościach, co prowadzi do lepszej interpretacji danych i bardziej precyzyjnych wyników.

Wyobraź sobie, że masz za zadanie odnaleźć konkretną informację w gigantycznym stosie dokumentów. Bez systemu Attention, musiałbyś przeczytać wszystko od deski do deski.

Z Attention, od razu wiesz, na których stronach szukać!

P: Dlaczego efektywność energetyczna transformerów jest tak istotnym zagadnieniem?

O: Wraz z rosnącą złożonością modeli AI, zapotrzebowanie na energię do ich trenowania i działania również rośnie. Transformery, choć potężne, mogą być energochłonne, co generuje wysokie koszty i ma negatywny wpływ na środowisko.

Optymalizacja efektywności energetycznej jest kluczowa dla zrównoważonego rozwoju AI, umożliwiając tworzenie bardziej ekologicznych i dostępnych rozwiązań.

To trochę jak z samochodami – superszybkie i mocne są fajne, ale jeśli pochłaniają tyle paliwa co czołg, to na dłuższą metę średnio się to opłaca. Dlatego szukamy “elektrycznych transformerów” – równie skutecznych, ale mniej prądożernych!

📚 Referencje

Wikipedia Encyclopedia

구글 검색 결과

구글 검색 결과

구글 검색 결과

구글 검색 결과

구글 검색 결과